본 요약문의 내용은 "Athens Journal of Sciences"에서 출판된 "[Quality Testing in Aluminum Die-Casting – A Novel Approach Using Acoustic Data in Neural Networks]" 논문을 기반으로 합니다.

1. 개요:

- 제목(Title): Quality Testing in Aluminum Die-Casting – A Novel Approach Using Acoustic Data in Neural Networks

- 저자(Author): Manfred Rössle & Stefan Pohl

- 발행 연도(Year of publication): 2024

- 발행 학술지/학회(Journal/academic society of publication): Athens Journal of Sciences

- 키워드(Keywords): acoustic quality control, aluminum die casting, convolutional neural networks, sound data

2. 초록 (Abstract):

알루미늄 다이캐스팅의 품질 관리에는 다양한 공정이 사용됩니다. 예를 들어, 부품의 밀도를 측정하거나, X선 이미지 또는 컴퓨터 단층 촬영(CT) 이미지를 분석합니다. 모든 일반적인 공정은 실용적으로 사용 가능한 결과를 도출합니다. 그러나 공정 시간과 하드웨어 비용 때문에 인라인 품질 관리에 적합한 공정이 없다는 문제가 발생합니다. 따라서 본 논문에서는 음향 샘플을 사용하는 빠르고 저렴한 품질 관리 공정 개념을 제시합니다. 240개의 알루미늄 주물에서 음향 샘플을 기록하고 X선 이미지를 사용하여 품질을 확인했습니다. 모든 부품은 결함이 없는 "양호(good)", 기공("블로우홀, blowholes")이 있는 "중간(medium)", 콜드 플로우 마크(cold flow marks)가 있는 "불량(poor)"의 세 가지 범주로 분류됩니다. 생성된 음향 샘플 처리를 위해 컨볼루션 뉴럴 네트워크(Convolutional Neuronal Network)가 개발되었습니다. 뉴럴 네트워크 훈련은 전체 음향 샘플과 분할된 음향 샘플("윈도잉, windowing") 모두를 사용하여 수행되었습니다. 생성된 모델들은 120개의 음향 샘플로 구성된 테스트 데이터셋으로 평가되었습니다. 결과는 매우 유망합니다. 두 모델은 각각 95%와 87%의 정확도(accuracy)를 보였습니다. 이 결과는 뉴럴 네트워크를 이용하여 새로운 음향 품질 관리 공정을 실현할 수 있음을 보여줍니다. 모델은 대부분의 알루미늄 주물을 올바른 범주로 분류합니다.

3. 서론 (Introduction):

신속하고 비용 효율적인 품질 관리는 제조 기업에서 중추적인 역할을 합니다. 현대적인 방법론, 특히 인공지능 및 뉴럴 네트워크와 같은 혁신 기술은 이러한 공정을 설계하는 데 완전히 새로운 가능성을 열어줍니다. 알루미늄 주물의 품질 보증을 위해 일반적으로 사용되는 방법은 컴퓨터 단층 촬영(CT) 및 X선 분석입니다. 이러한 방법은 부품 이미지를 촬영하여 기공("블로우홀, blowholes")이나 균열(cracks)과 같은 결함을 탐지하는 데 효과적입니다. 그러나 CT 스캔과 같은 방법은 일반적인 공정 시간(개당 약 30초)에 비해 기록 시간(개당 20-30분!)이 현저히 길어, 의미 있는 인라인 공정 제어(inline process control)에는 실현 불가능합니다. 본 연구는 뉴럴 네트워크를 이용한 음향 데이터 처리가 빠르고 저렴하며 인라인 적용이 가능한 품질 보증 방법으로서 실행 가능한지 검토합니다. 제조 결함이 주물의 밀도를 변경시켜 음향 특성(소리 및 주파수)을 변화시키며, 이를 뉴럴 네트워크가 식별할 수 있다는 가설에 기반합니다.

4. 연구 요약 (Summary of the study):

연구 주제의 배경 (Background of the research topic):

알루미늄 다이캐스팅의 품질 관리는 밀도 측정, X선 이미징, 컴퓨터 단층 촬영과 같은 방법에 의존합니다. 이러한 방법들은 효과적이지만, 속도와 비용 측면에서 한계가 있어 생산 중 인라인 품질 관리에 적용하기 어렵습니다.

이전 연구 현황 (Status of previous research):

음성, 음악, 패턴 인식과 같은 응용 분야에서 뉴럴 네트워크를 이용한 오디오 데이터 처리 분야는 상당한 진전을 이루었습니다. 기술에는 원시 오디오 데이터 처리 또는 스펙트로그램(spectrograms)이나 멜 주파수 켑스트럼 계수(Mel Frequency Cepstral Coefficients, MFCC)와 같은 이미지 표현 처리가 포함되며, 종종 컨볼루션 뉴럴 네트워크(Convolutional Neural Networks, CNNs)가 사용됩니다. 뉴럴 네트워크를 이용한 알루미늄 다이캐스팅의 음향 품질 보증에 대한 구체적인 연구는 부족하지만, 관련 연구로는 X선 이미지와 CNN을 이용한 자동 주물 품질 관리, 용접부, 세라믹 타일, 기어박스 등의 음향 품질 관리 등이 있습니다.

연구 목적 (Purpose of the study):

본 연구는 음향 데이터를 뉴럴 네트워크로 분석하여 알루미늄 다이캐스팅을 위한 새롭고 빠르며 저렴한 인라인 품질 관리 공정을 구축하는 것의 실현 가능성을 조사하는 것을 목표로 합니다. 핵심 아이디어는 재료 밀도를 변화시키는 결함이 훈련된 네트워크에 의해 감지될 수 있는 뚜렷한 음향 패턴을 생성한다는 것입니다.

핵심 연구 (Core study):

본 연구는 X선 검사를 통해 사전에 "양호(good)"(결함 없음), "중간(medium)"(기공/"블로우홀"), "불량(poor)"(콜드 플로우 마크) 범주(각 80개)로 분류된 240개의 알루미늄 주물에서 음향 샘플을 기록하는 것을 포함했습니다. 소리는 통제된 조건 하에서 진자(pendulum)를 사용하여 부품을 타격함으로써 생성되었습니다. 기존 아키텍처(예: VGG Net)에서 영감을 받아 컨볼루션 뉴럴 네트워크(CNN)가 개발되었습니다. 네트워크는 음향 샘플에서 파생된 멜 주파수 켑스트럼 계수(MFCC)를 사용하여 훈련되었습니다. 두 가지 훈련 접근법이 비교되었습니다: 전체 음향 샘플 사용과 데이터셋 크기를 인위적으로 늘리기 위한 분할된 음향 샘플("윈도잉") 사용. 훈련된 모델은 별도의 테스트 데이터셋에서 평가되었습니다.

5. 연구 방법론 (Research Methodology)

연구 설계 (Research Design):

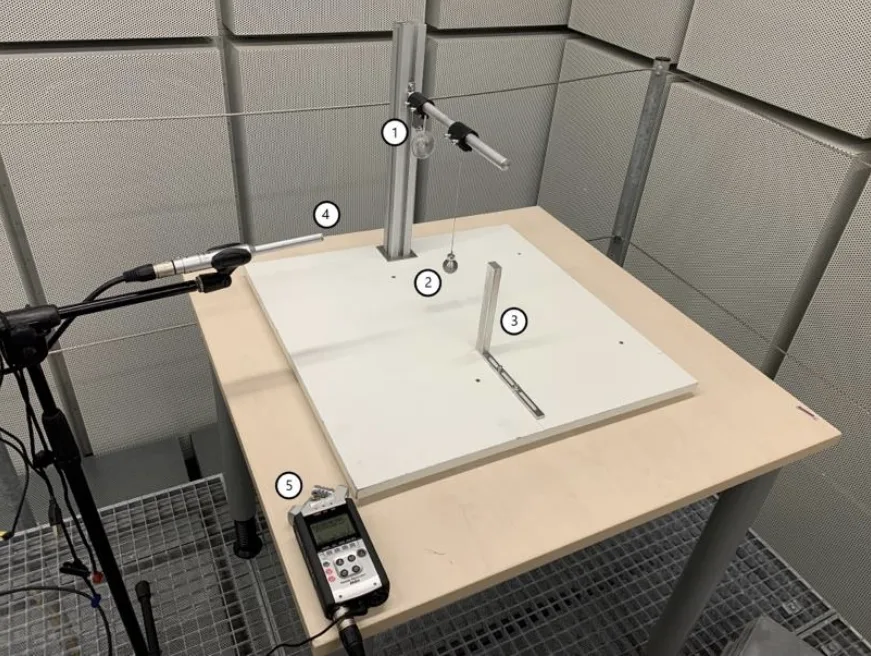

명확한 품질 범주를 보장하기 위해 특정하고 "극단적인(extreme)" 매개변수로 생산된 240개의 알루미늄 주물을 사용하는 실험 설계를 채택했습니다. 음향 샘플은 통제된 환경(방음실)에서 기록되었습니다. 맞춤형 고정 장치(holding fixture)와 진자 설정(Figure 1)이 일관성을 보장했습니다. 오디오 분류의 확립된 관행에 기반하여 CNN 아키텍처가 설계되었습니다. 두 가지 훈련 전략(전체 샘플 대 분할 샘플)이 구현되었고 10-겹 교차 검증(10-fold cross-validation)을 사용하여 평가되었습니다.

데이터 수집 및 분석 방법 (Data Collection and Analysis Methods):

- 데이터 출처: Aalen University 주조소에서 제공된 240개의 알루미늄 주물(19.8 x 14.8 x 0.4 cm). 다이캐스팅 전문가가 X선 이미지를 사용하여 "양호", "중간", "불량"으로 분류.

- 음향 기록: Zoom Handy Recorder H4n 및 Behringer ECM8000 마이크를 사용하여 방음실에서 수행. WAV 형식(96kHz, 24비트, 모노)으로 기록. 주물당 2개의 샘플(총 480개 샘플).

- 전처리: 임계값을 사용하여 초기/최종 무음 구간을 제거하도록 음향 파일을 절단하고, 5초 길이로 표준화했으며, 96kHz에서 16kHz로 리샘플링(resampling)함.

- 특징 추출: 전처리된 오디오 데이터에서 멜 주파수 켑스트럼 계수(MFCC)를 계산함.

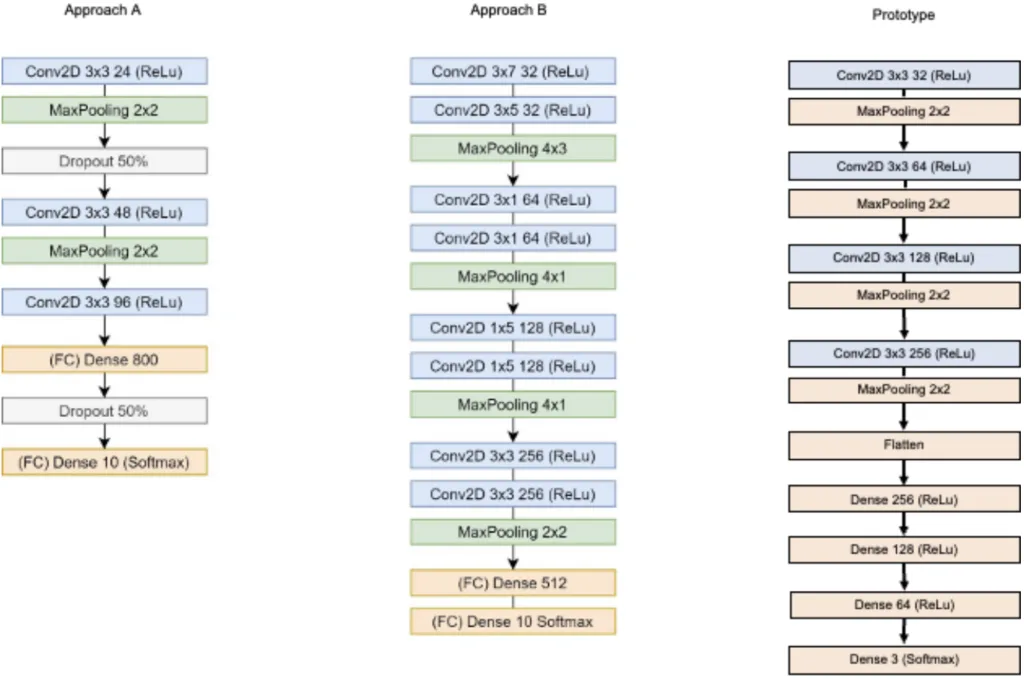

- 모델: 컨볼루션 뉴럴 네트워크(CNN) 프로토타입 개발 (Figure 2, Prototype). Conv2D(3x3 필터, 32개에서 256개로 두 배 증가) 및 MaxPooling(2x2)의 4개 블록, Flatten 레이어, 4개의 Dense 레이어(256, 128, 64, 3 유닛)로 구성. 최종 Softmax 레이어를 제외하고 ReLu 활성화 함수 사용.

- 훈련: Python 라이브러리(명시되지는 않았으나 Keras/TensorFlow로 추정)를 사용하여 수행. 두 가지 방법:

- 전체 샘플: 전체 5초 샘플의 MFCC (360개 훈련 샘플).

- 분할 샘플: 무작위 2초 세그먼트의 MFCC, 데이터 증강을 위해 20,000회 반복.

훈련은 75% 훈련 분할(360개 샘플)에 대해 10-겹 교차 검증을 사용했으며, 나머지 25%(120개 샘플)는 테스트 세트로 사용. 매개변수에는 Categorical Crossentropy 손실 함수, Adam 옵티마이저, Accuracy 메트릭 포함 (Table 2).

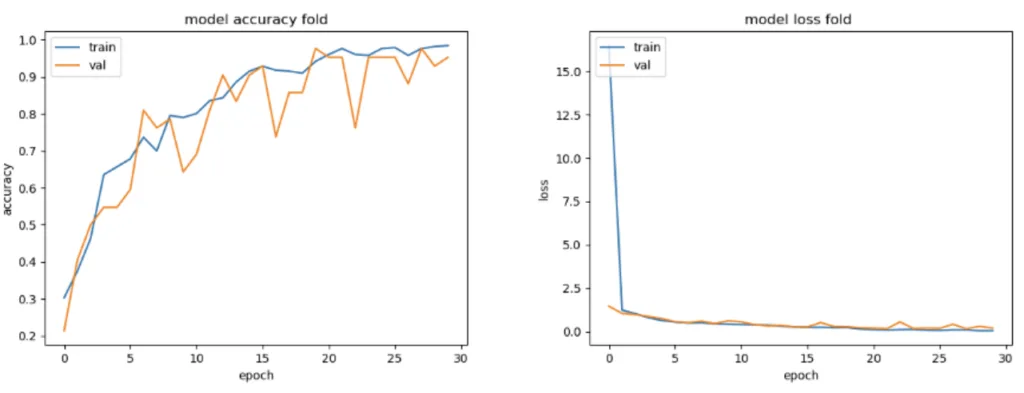

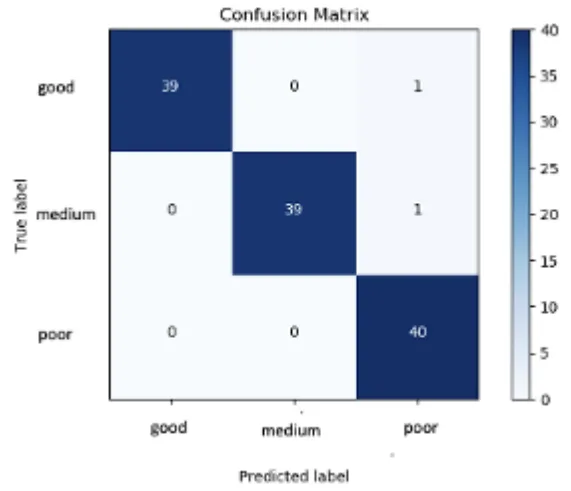

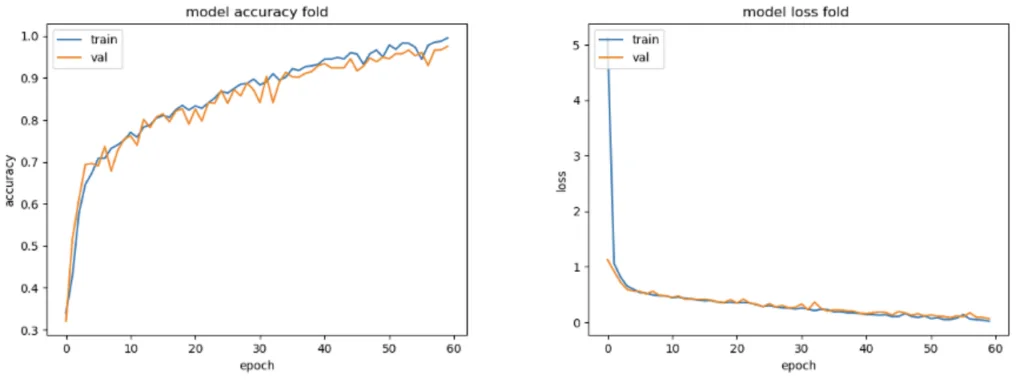

- 평가: 모델 성능은 훈련 중 정확도(Accuracy) 및 손실(Loss) 곡선(Figure 3, Figure 5)과 테스트 세트에 대한 혼동 행렬(confusion matrices)(Figure 4, Figure 6)을 사용하여 평가됨. 분류 확률 값 분석 (Table 4).

연구 주제 및 범위 (Research Topics and Scope):

연구 범위는 다양한 품질의 알루미늄 다이캐스팅에서 음향 데이터 획득, 이 데이터의 전처리, MFCC 특징 추출, 분류를 위한 CNN 모델 개발 및 훈련, 소리를 기반으로 "양호", "중간", "불량" 품질 주물을 구별하는 모델 능력 평가를 포함합니다. 이 연구는 전체 음향 샘플과 분할 음향 샘플을 사용한 훈련의 효과를 비교합니다.

6. 주요 결과 (Key Results):

주요 결과 (Key Results):

- CNN을 이용한 제안된 음향 품질 관리 방법은 유망한 결과를 보여주었습니다.

- 전체 음향 샘플로 훈련된 모델은 테스트 데이터셋(120개 샘플)에서 95%의 정확도(accuracy)를 달성했습니다. 혼동 행렬(Figure 4)은 단 두 건의 오분류를 보여주었습니다: "양호" 샘플 1개와 "중간" 샘플 1개가 "불량"으로 분류되었습니다.

- 분할 음향 샘플로 훈련된 모델은 테스트 데이터셋에서 평균 87%의 정확도(10개 폴드 중 최고 모델 90%, 최저 모델 86%, Table 3)를 달성했습니다. 혼동 행렬(Figure 6)은 더 많은 오분류를 나타냈으며, 특히 "양호" 및 "중간" 샘플을 잘못 할당하는 경우가 있었습니다.

- 훈련 곡선(정확도 및 손실, Figure 3 & 5) 분석 결과, 최적의 훈련 에포크(전체 샘플 30, 분할 샘플 60)가 제안되었으며, 테스트된 조건 하에서 두 방법 모두 심각한 과적합(overfitting)을 나타내지 않았습니다.

- 명확한 분류를 보장하기 위해 분류 확률 임계값(예: 80%)을 설정하면 두 모델 모두에서 오분류된 샘플 수가 크게 증가했습니다.

- 본 연구는 CNN으로 처리된 음향 신호를 기반으로 주물 품질을 구별할 수 있는 가능성을 성공적으로 입증했습니다.

그림 이름 목록 (Figure Name List):

- Figure 1. Design of Experiment

- Figure 2. Architectures of CNNs

- Figure 3. Model Accuracy and Loss for Complete Sound Samples

- Figure 4. Confusion Matrix for Complete Sound Samples

- Figure 5. Model Accuracy and Loss for Segmented Sound Samples

- Figure 6. Confusion Matrix for Segmented Sound Samples

7. 결론 (Conclusion):

얻어진 결과는 뉴럴 네트워크에서 음향 데이터 처리를 활용하는 새로운 인라인 품질 보증 공정이 알루미늄 다이캐스팅에 대해 기본적으로 실현 가능함을 나타냅니다. 이 접근법은 음향 반응을 기반으로 부품을 품질 범주로 성공적으로 분류했습니다. 그러나 본 연구는 작은 데이터셋 크기, 극단적인 매개변수로 주조된 부품 사용(생산에서 흔한 "회색 영역"을 대표하지 않음), 테스트 부품의 단순한 형상, 일반적인 제조 소음이 없는 통제된 실험실 환경 등 한계를 강조합니다. 실제 구현 전에 이러한 한계를 해결하고, 더 큰 데이터셋과 더 복잡한 부품으로 접근법을 검증하며, 실제 제조 환경에서의 견고성을 평가하기 위한 추가 조사가 필요합니다.

8. 참고 문헌 (References):

- Abdoli S, Cardinal P, Lameiras Koerich A (2019) End-to-end environmental sound classification using a 1D convolutional neural network. Expert Systems with Applications 136(Dec): 252–263.

- Boddapati V, Petef A, Rasmusson J, Lundberg L (2017) Classifying environmental sounds using image recognition networks. Procedia Computer Science 112: 2048–2056.

- Costa YMG, Oliveira LS, Silla CN (2017) An evaluation of Convolutional Neural Networks for music classification using spectrograms. Applied Soft Computing 52(C): 28–38.

- Cunha R, Medeiros De Araujo G, Maciel R, Nandi GS, Da-Ros MR, et al. (2018) Applying non-destructive testing and machine learning to ceramic tile quality control. In SBESC 2018. 2018 VIII Brazilian Symposium on Computing Systems Engineering: Proceedings, 54–61. Salvador, Brazil, November 6-9, 2018. Los Alamitos, CA: Conference Publishing Services, IEEE Computer Society.

- Gulli A (2017) Deep learning with Keras. Implement neural networks with Keras on Theano and TensorFlow. Birmingham, UK: Packt Publishing.

- Hassan SU, Zeeshan Khan M, Ghani Khan MU, Saleem S (2019) Robust sound classification for surveillance using time frequency audio features. In 2019 International Conference on Communication Technologies (ComTech), 13–18. 20-21 March, 2019, Military College of Signals, National University of Sciences & Technology. Piscataway, New Jersey: IEEE.

- Huzaifah M (2017) Comparison of time-frequency representations for environmental sound classification using convolutional neural networks. Available at: https://arxiv.org/pdf/1706.07156.

- Jing L, Zhao M, Li P, Xu X (2017) A convolutional neural network based feature learning and fault diagnosis method for the condition monitoring of gearbox. Measurement 111(Dec): 1-10.

- Khamparia A, Gupta D, Nguyen NG, Khanna A, Pandey B, Tiwari P (2019) Sound classification using convolutional neural network and tensor deep stacking network. IEEE Access 7(Jan): 7717–7727.

- Kong Z, Tang B, Deng L, Liu W, Han Y (2020) Condition monitoring of wind turbines based on spatiotemporal fusion of SCADA data by convolutional neural networks and gated recurrent units. Renewable Energy 146(Feb): 760–768.

- Kothuru A, Nooka SP, Liu R (2019) Application of deep visualization in CNN-based tool condition monitoring for end milling. Procedia Manufacturing 34: 995–1004.

- Krizhevsky A, Sutskever I, Hinton GE (2017) ImageNet classification with deep convolutional neural networks. Communications of the ACM 60(6): 84–90.

- Lai J-H, Liu C-L, Chen X, Zhou J, Tan T, Zheng N, et al. (2018) Pattern Recognition and Computer Vision. Cham: Springer International Publishing.

- Lv N, Xu Y, Li S, Yu X, Chen S (2017) Automated control of welding penetration based on audio sensing technology. Journal of Materials Processing Technology 250: 81–98.

- Mery D (2020) Aluminum casting inspection using deep learning: a method based on convolutional neural networks. Journal of Nondestructive Evaluation 39(1): 1–13.

- Moolayil J (2019) Learn keras for deep neural networks. Berkeley, CA: Apress.

- Nguyen TP, Choi S, Park S-J, Park SH, Yoon J (2020) Inspecting method for defective casting products with convolutional neural network (CNN). International Journal of Precision Engineering and Manufacturing-Green Technology 8(Feb): 583–594.

- Nie J-Y, Obradovic Z, Suzumura T, Ghosh R, Nambiar R, Wang C (Eds.) (2017) 2017 IEEE International Conference on Big Data. Dec 11-14, 2017, Boston, MA, USA: Proceedings. Piscataway, NJ: IEEE.

- Olson DL, Delen D (2008) advanced data mining techniques. Berlin, Heidelberg: Springer-Verlag Berlin Heidelberg.

- Piczak KJ (2015) Environmental sound classification with convolutional neural networks. In D Erdoğmuş (ed.), 2015 IEEE 25th International Workshop on Machine Learning for Signal Processing (MLSP), 1–6. 17-20 Sept. 2015, Boston, USA. Piscataway, NJ: IEEE.

- Przybył K, Duda A, Koszela K, Stangierski J, Polarczyk M, Gierz L (2020) Classification of Dried Strawberry by the Analysis of the Acoustic Sound with Artificial Neural Networks. Sensors (Basel, Switzerland) 20(2): 499.

- Purwins H, Li B, Virtanen T, Schluter J, Chang S-Y, Sainath T (2019) Deep learning for audio signal processing. IEEE Journal of Selected Topics in Signal Processing 13(2): 206-219.

- Salamon J, Bello JP (2017) Deep convolutional neural networks and data augmentation for environmental sound classification. IEEE Signal Processing Letters 24(3): 279–283.

- Simonyan K, Zisserman A (2014) Very deep convolutional networks for large-scale image recognition. https://arxiv.org/pdf/1409.1556

- Voith (2020) OnCare. Available at: http://voith.com/corp-de/products-services/automatio n-digit al-solutions/oncare.html?

- Wani MA, Bhat FA, Afzal S, Khan AI (2020) Advances in deep learning. Singapore: Springer.

- Yuji Tokozume TH (2017) Learning environmental sounds with end-to-end convolutional neural network. IEEE.

9. 저작권 (Copyright):

- 본 자료는 "Manfred Rössle & Stefan Pohl"의 논문을 요약한 것입니다. 기반 논문: "Quality Testing in Aluminum Die-Casting – A Novel Approach Using Acoustic Data in Neural Networks".

- 논문 출처: https://doi.org/10.30958/ajs.X-Y-Z

본 자료는 상기 논문을 기반으로 요약되었으며, 상업적 목적의 무단 사용을 금지합니다.

Copyright © 2025 CASTMAN. All rights reserved.