本要約の内容は、「Athens Journal of Sciences」によって発行された論文「Quality Testing in Aluminum Die-Casting – A Novel Approach Using Acoustic Data in Neural Networks」に基づいています。

1. 概要:

- タイトル (Title): Quality Testing in Aluminum Die-Casting – A Novel Approach Using Acoustic Data in Neural Networks

- 著者 (Author): Manfred Rössle & Stefan Pohl

- 発行年 (Year of publication): 2024

- 発行学術誌/学会 (Journal/academic society of publication): Athens Journal of Sciences

- キーワード (Keywords): acoustic quality control, aluminum die casting, convolutional neural networks, sound data

2. 抄録 (Abstract):

アルミニウムダイカストの品質管理には様々なプロセスが用いられる。例えば、部品の密度測定、X線画像やCT(コンピュータ断層撮影)画像の解析などがある。これらの一般的なプロセスはいずれも実用的な結果をもたらす。しかし、その処理時間やハードウェアコストのため、インライン品質管理に適したプロセスがないという問題がある。そこで本稿では、音響サンプルを用いた高速かつ低コストな品質管理プロセスのコンセプトを提案する。240個のアルミニウム鋳造品の音響サンプルを記録し、X線画像を用いて品質を確認した。全ての部品は、欠陥のない「良品(good)」、空気混入(「ブローホール, blowholes」)のある「中程度(medium)」、湯境(cold flow marks)のある「不良品(poor)」のカテゴリに分類された。生成された音響サンプルの処理のために、畳み込みニューラルネットワーク(Convolutional Neuronal Network)が開発された。ニューラルネットワークのトレーニングは、完全な音響サンプルとセグメント化された音響サンプル(「ウィンドウイング, windowing」)の両方を用いて行われた。生成されたモデルは、120個の音響サンプルからなるテストデータセットで評価された。結果は非常に有望であり、両モデルはそれぞれ95%と87%の精度(accuracy)を示した。この結果は、ニューラルネットワークを利用することで、新しい音響品質管理プロセスが実現可能であることを示している。モデルはほとんどのアルミニウム鋳造品を正しいカテゴリに分類した。

3. 序論 (Introduction):

迅速かつコスト効率の高い品質管理は、製造業において中心的な役割を果たす。現代的な手法、特に人工知能やニューラルネットワークなどの革新的技術は、そのようなプロセスを設計するための全く新しい可能性を開く。アルミニウム鋳造品の品質保証に頻繁に用いられる手法には、CTやX線検査がある。これらは、部品の画像を撮影し、空気溜まり(「ブローホール」)や亀裂(cracks)などの欠陥を検出する。しかし、CTスキャンなどは、一般的なプロセス時間(1個あたり約30秒)と比較して記録時間(1個あたり20~30分!)が著しく長く、意味のあるインライン工程管理(inline process control)には現実的ではない。本研究では、ニューラルネットワークを用いた音響データ処理が、高速、低コスト、かつインライン対応可能な品質保証方法として実行可能かどうかを検討する。その根底にある仮説は、製造上の欠陥が鋳造品の密度を変化させ、それによって音響特性(音と周波数)が変化し、これをニューラルネットワークが識別できるというものである。

4. 研究の要約 (Summary of the study):

研究テーマの背景 (Background of the research topic):

アルミニウムダイカストの品質管理は、密度測定、X線イメージング、CTなどの手法に依存している。これらの手法は効果的であるが、速度とコストの面で限界があり、生産中のインライン品質管理への適用を妨げている。

先行研究の状況 (Status of previous research):

音声、音楽、パターン認識などの応用分野において、ニューラルネットワークを用いたオーディオデータ処理は大きな進歩を遂げている。技術には、生オーディオデータの処理や、スペクトログラム(spectrograms)やメル周波数ケプストラム係数(Mel Frequency Cepstral Coefficients, MFCC)のような画像表現の処理が含まれ、しばしば畳み込みニューラルネットワーク(Convolutional Neural Networks, CNNs)が用いられる。ニューラルネットワークを用いたアルミニウムダイカストの音響品質保証に関する具体的な研究は不足しているが、関連研究としては、X線画像とCNNを用いた自動鋳造品質管理、溶接部、セラミックタイル、ギアボックスなどの音響品質管理がある。

研究の目的 (Purpose of the study):

本研究は、音響データをニューラルネットワークで解析することにより、アルミニウムダイカストのための新規、高速、かつ低コストなインライン品質管理プロセスを確立することの実現可能性を調査することを目的とする。中心的なアイデアは、材料密度を変化させる欠陥が、訓練されたネットワークによって検出可能な明確な音響パターンを生成するというものである。

中核研究 (Core study):

本研究では、X線検査によって事前に「良品」(欠陥なし)、「中程度」(空気混入/「ブローホール」)、「不良品」(湯境)のカテゴリ(各80個)に分類された240個のアルミニウム鋳造品から音響サンプルを記録した。音は、制御された条件下で振り子(pendulum)を用いて部品を打撃することによって生成された。既存のアーキテクチャ(例:VGG Net)に着想を得て、畳み込みニューラルネットワーク(CNN)が開発された。ネットワークは、音響サンプルから導出されたメル周波数ケプストラム係数(MFCC)を用いて訓練された。2つの訓練アプローチが比較された:完全な音響サンプルの使用と、データセットサイズを人為的に増加させるためのセグメント化された音響サンプル(「ウィンドウイング」)の使用。訓練されたモデルは、別のテストデータセットで評価された。

5. 研究方法論 (Research Methodology)

研究デザイン (Research Design):

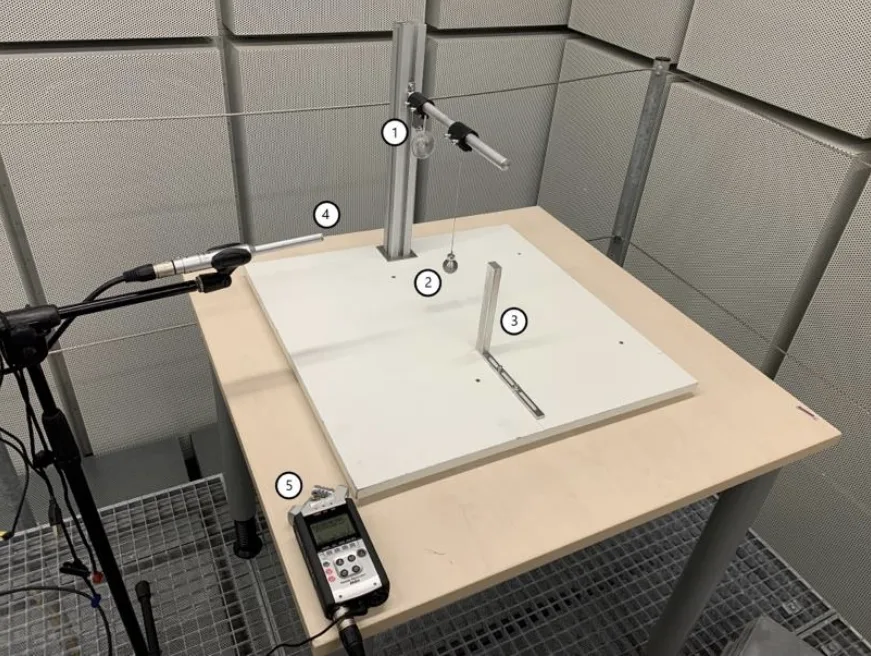

明確な品質カテゴリを保証するために、特定の「極端な(extreme)」パラメータで製造された240個のアルミニウム鋳造品を用いた実験計画を採用した。音響サンプルは制御された環境(防音室)で記録された。特注の保持具(holding fixture)と振り子設定(Figure 1)が再現性を保証した。オーディオ分類における確立された実践に基づき、CNNアーキテクチャが設計された。2つの訓練戦略(完全サンプル対セグメント化サンプル)が実装され、10分割交差検証(10-fold cross-validation)を用いて評価された。

データ収集・分析方法 (Data Collection and Analysis Methods):

- データソース: Aalen University鋳造所から提供された240個のアルミニウム鋳造品(19.8 x 14.8 x 0.4 cm)。ダイカスト専門家がX線画像を用いて「良品」、「中程度」、「不良品」に分類。

- 音響記録: Zoom Handy Recorder H4nおよびBehringer ECM8000マイクロフォンを使用し、防音室で実施。WAV形式(96kHz、24ビット、モノラル)で記録。鋳造品あたり2サンプル(合計480サンプル)。

- 前処理: 閾値を用いて最初と最後の無音部分を除去するように音響ファイルをカットし、5秒の長さに標準化し、96kHzから16kHzにリサンプリング(resampling)した。

- 特徴抽出: 前処理されたオーディオデータからメル周波数ケプストラム係数(MFCC)を計算した。

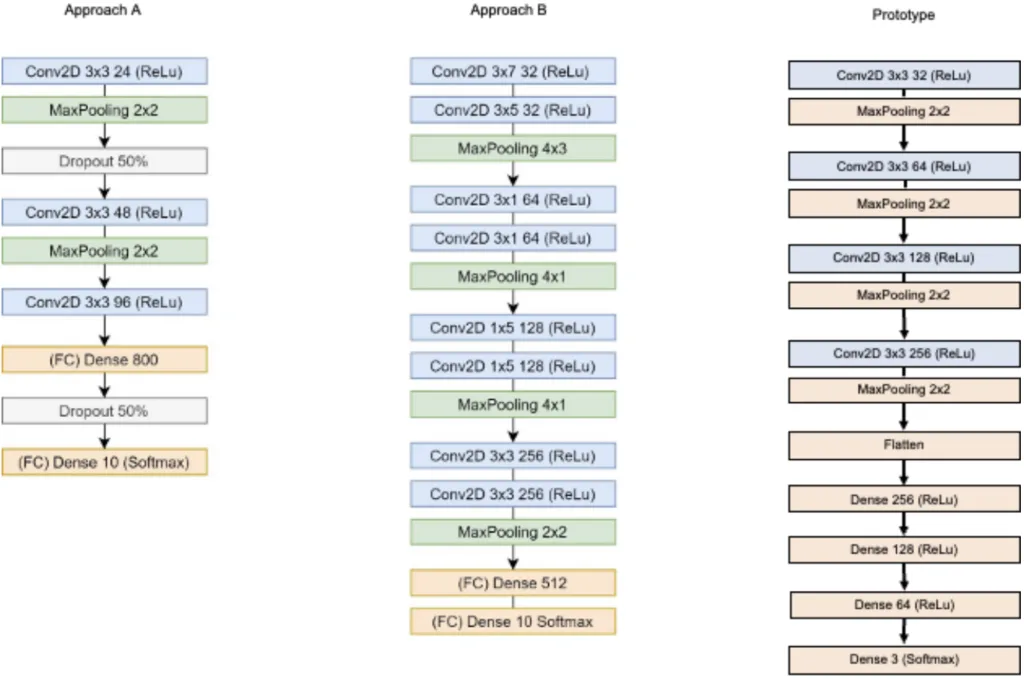

- モデル: 畳み込みニューラルネットワーク(CNN)プロトタイプを開発(Figure 2, Prototype)。Conv2D(3x3フィルタ、32から256へ倍増)とMaxPooling(2x2)の4つのブロック、Flatten層、4つのDense層(256、128、64、3ユニット)で構成。最終Softmax層を除きReLu活性化関数を使用。

- 訓練: Pythonライブラリ(明示されていないがおそらくKeras/TensorFlow)を使用して実施。2つの方法:

- 完全サンプル: 全5秒サンプルのMFCC(360訓練サンプル)。

- セグメント化サンプル: ランダムな2秒セグメントのMFCC、データ拡張のために20,000回繰り返す。

訓練は75%の訓練分割(360サンプル)に対して10分割交差検証を使用し、残りの25%(120サンプル)をテストセットとした。パラメータにはCategorical Crossentropy損失関数、Adamオプティマイザ、Accuracyメトリックが含まれる(Table 2)。

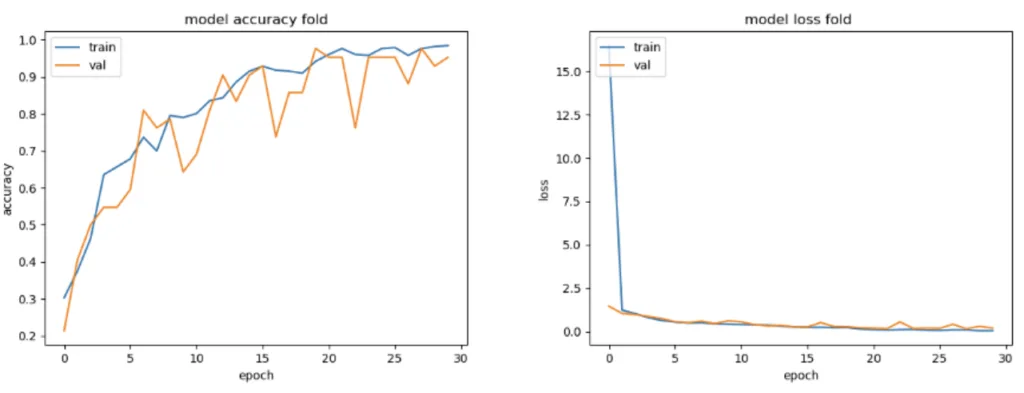

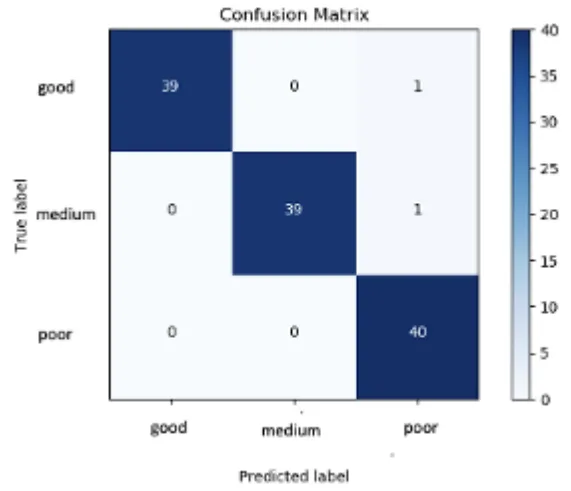

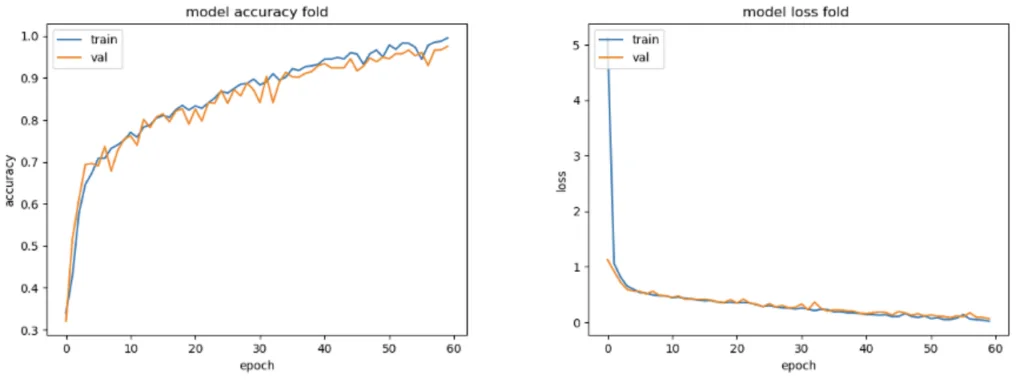

- 評価: モデル性能は、訓練中の精度(Accuracy)と損失(Loss)曲線(Figure 3, Figure 5)およびテストセットに対する混同行列(confusion matrices)(Figure 4, Figure 6)を用いて評価された。分類確率値を分析(Table 4)。

研究テーマと範囲 (Research Topics and Scope):

研究範囲は、様々な品質のアルミニウムダイカストからの音響データ取得、このデータの前処理、MFCC特徴抽出、分類のためのCNNモデル開発と訓練、そして音に基づいて「良品」、「中程度」、「不良品」の品質鋳造品を区別するモデル能力の評価を網羅する。本研究は、完全な音響サンプルとセグメント化された音響サンプルを用いた訓練の効果を比較する。

6. 主要な結果 (Key Results):

主要な結果 (Key Results):

- CNNを用いた提案された音響品質管理手法は、有望な結果を示した。

- 完全な音響サンプルで訓練されたモデルは、テストデータセット(120サンプル)において95%の精度(accuracy)を達成した。混同行列(Figure 4)は、わずか2つの誤分類を示した:「良品」サンプル1つと「中程度」サンプル1つが「不良品」として分類された。

- セグメント化された音響サンプルで訓練されたモデルは、テストデータセットにおいて平均87%の精度(10分割中、最良モデル90%、最悪モデル86%、Table 3)を達成した。混同行列(Figure 6)はより多くの誤分類を示し、特に「良品」および「中程度」サンプルを誤って割り当てるケースがあった。

- 訓練曲線(精度と損失、Figure 3 & 5)の分析は、最適な訓練エポック数(完全サンプルで30、セグメント化サンプルで60)を示唆し、テストされた条件下ではどちらの方法でも重大な過学習(overfitting)を示さなかった。

- 明確な分類を保証するために分類確率閾値(例:80%)を設定すると、両モデルで誤分類されるサンプル数が大幅に増加した。

- 本研究は、CNNによって処理された音響シグネチャに基づいて鋳造品質を区別できる可能性を成功裏に実証した。

図の名称リスト (Figure Name List):

- Figure 1. Design of Experiment (実験計画の設計)

- Figure 2. Architectures of CNNs (CNNのアーキテクチャ)

- Figure 3. Model Accuracy and Loss for Complete Sound Samples (完全音響サンプルに対するモデルの精度と損失)

- Figure 4. Confusion Matrix for Complete Sound Samples (完全音響サンプルに対する混同行列)

- Figure 5. Model Accuracy and Loss for Segmented Sound Samples (セグメント化音響サンプルに対するモデルの精度と損失)

- Figure 6. Confusion Matrix for Segmented Sound Samples (セグメント化音響サンプルに対する混同行列)

7. 結論 (Conclusion):

得られた結果は、ニューラルネットワークにおける音響データ処理を利用した新しいインライン品質保証プロセスが、アルミニウムダイカストに対して基本的に実現可能であることを示している。このアプローチは、音響応答に基づいて部品を品質カテゴリに成功裏に分類した。しかし、本研究は、データセットサイズが小さいこと、極端なパラメータで鋳造された部品の使用(生産で一般的な「グレーゾーン」を代表していない)、テスト部品の単純な形状、一般的な製造ノイズがない制御された実験室環境など、限界点を強調している。実用化に先立ち、これらの限界に対処し、より大きなデータセットとより複雑な部品でアプローチを検証し、実際の製造環境における堅牢性を評価するためのさらなる調査が必要である。

8. 参考文献 (References):

- Abdoli S, Cardinal P, Lameiras Koerich A (2019) End-to-end environmental sound classification using a 1D convolutional neural network. Expert Systems with Applications 136(Dec): 252–263.

- Boddapati V, Petef A, Rasmusson J, Lundberg L (2017) Classifying environmental sounds using image recognition networks. Procedia Computer Science 112: 2048–2056.

- Costa YMG, Oliveira LS, Silla CN (2017) An evaluation of Convolutional Neural Networks for music classification using spectrograms. Applied Soft Computing 52(C): 28–38.

- Cunha R, Medeiros De Araujo G, Maciel R, Nandi GS, Da-Ros MR, et al. (2018) Applying non-destructive testing and machine learning to ceramic tile quality control. In SBESC 2018. 2018 VIII Brazilian Symposium on Computing Systems Engineering: Proceedings, 54–61. Salvador, Brazil, November 6-9, 2018. Los Alamitos, CA: Conference Publishing Services, IEEE Computer Society.

- Gulli A (2017) Deep learning with Keras. Implement neural networks with Keras on Theano and TensorFlow. Birmingham, UK: Packt Publishing.

- Hassan SU, Zeeshan Khan M, Ghani Khan MU, Saleem S (2019) Robust sound classification for surveillance using time frequency audio features. In 2019 International Conference on Communication Technologies (ComTech), 13–18. 20-21 March, 2019, Military College of Signals, National University of Sciences & Technology. Piscataway, New Jersey: IEEE.

- Huzaifah M (2017) Comparison of time-frequency representations for environmental sound classification using convolutional neural networks. Available at: https://arxiv.org/pdf/1706.07156.

- Jing L, Zhao M, Li P, Xu X (2017) A convolutional neural network based feature learning and fault diagnosis method for the condition monitoring of gearbox. Measurement 111(Dec): 1-10.

- Khamparia A, Gupta D, Nguyen NG, Khanna A, Pandey B, Tiwari P (2019) Sound classification using convolutional neural network and tensor deep stacking network. IEEE Access 7(Jan): 7717–7727.

- Kong Z, Tang B, Deng L, Liu W, Han Y (2020) Condition monitoring of wind turbines based on spatiotemporal fusion of SCADA data by convolutional neural networks and gated recurrent units. Renewable Energy 146(Feb): 760–768.

- Kothuru A, Nooka SP, Liu R (2019) Application of deep visualization in CNN-based tool condition monitoring for end milling. Procedia Manufacturing 34: 995–1004.

- Krizhevsky A, Sutskever I, Hinton GE (2017) ImageNet classification with deep convolutional neural networks. Communications of the ACM 60(6): 84–90.

- Lai J-H, Liu C-L, Chen X, Zhou J, Tan T, Zheng N, et al. (2018) Pattern Recognition and Computer Vision. Cham: Springer International Publishing.

- Lv N, Xu Y, Li S, Yu X, Chen S (2017) Automated control of welding penetration based on audio sensing technology. Journal of Materials Processing Technology 250: 81–98.

- Mery D (2020) Aluminum casting inspection using deep learning: a method based on convolutional neural networks. Journal of Nondestructive Evaluation 39(1): 1–13.

- Moolayil J (2019) Learn keras for deep neural networks. Berkeley, CA: Apress.

- Nguyen TP, Choi S, Park S-J, Park SH, Yoon J (2020) Inspecting method for defective casting products with convolutional neural network (CNN). International Journal of Precision Engineering and Manufacturing-Green Technology 8(Feb): 583–594.

- Nie J-Y, Obradovic Z, Suzumura T, Ghosh R, Nambiar R, Wang C (Eds.) (2017) 2017 IEEE International Conference on Big Data. Dec 11-14, 2017, Boston, MA, USA: Proceedings. Piscataway, NJ: IEEE.

- Olson DL, Delen D (2008) advanced data mining techniques. Berlin, Heidelberg: Springer-Verlag Berlin Heidelberg.

- Piczak KJ (2015) Environmental sound classification with convolutional neural networks. In D Erdoğmuş (ed.), 2015 IEEE 25th International Workshop on Machine Learning for Signal Processing (MLSP), 1–6. 17-20 Sept. 2015, Boston, USA. Piscataway, NJ: IEEE.

- Przybył K, Duda A, Koszela K, Stangierski J, Polarczyk M, Gierz L (2020) Classification of Dried Strawberry by the Analysis of the Acoustic Sound with Artificial Neural Networks. Sensors (Basel, Switzerland) 20(2): 499.

- Purwins H, Li B, Virtanen T, Schluter J, Chang S-Y, Sainath T (2019) Deep learning for audio signal processing. IEEE Journal of Selected Topics in Signal Processing 13(2): 206-219.

- Salamon J, Bello JP (2017) Deep convolutional neural networks and data augmentation for environmental sound classification. IEEE Signal Processing Letters 24(3): 279–283.

- Simonyan K, Zisserman A (2014) Very deep convolutional networks for large-scale image recognition. https://arxiv.org/pdf/1409.1556

- Voith (2020) OnCare. Available at: http://voith.com/corp-de/products-services/automatio n-digit al-solutions/oncare.html?

- Wani MA, Bhat FA, Afzal S, Khan AI (2020) Advances in deep learning. Singapore: Springer.

- Yuji Tokozume TH (2017) Learning environmental sounds with end-to-end convolutional neural network. IEEE.

9. 著作権 (Copyright):

- 本資料は、「Manfred Rössle & Stefan Pohl」による論文の要約です。基論文:「Quality Testing in Aluminum Die-Casting – A Novel Approach Using Acoustic Data in Neural Networks」。

- 論文出典:https://doi.org/10.30958/ajs.X-Y-Z

本資料は上記の論文に基づいて要約されており、商業目的での無断使用を禁じます。

Copyright © 2025 CASTMAN. All rights reserved.